Op 1 augustus is de Artificial intelligence Act (AI Act) in werking getreden. Deze wetgeving vormt het eerste Europese juridische kader voor artificiële intelligentie (AI). AI is onmisbaar geworden in veel sectoren, maar het brengt ook risico's met zich mee. Deze wetgeving is opgesteld om de veiligheid te garanderen en heeft zo ook als doel om consumenten meer vertrouwen te geven in AI-systemen.

Hoewel niet elk AI-systeem risicovol is, kunnen bepaalde systemen wel risico's met zich meebrengen. AI kan fouten maken, soms werkt het als een 'black box', het kan discriminerende resultaten opleveren, of een chatbot kan foutieve of zelfs gevaarlijke informatie verspreiden. Daarom is er een duidelijke regelgeving nodig. De Europese AI Act is de eerste wetgeving voor AI om zo ook de risico’s die erbij komen kijken te beperken.

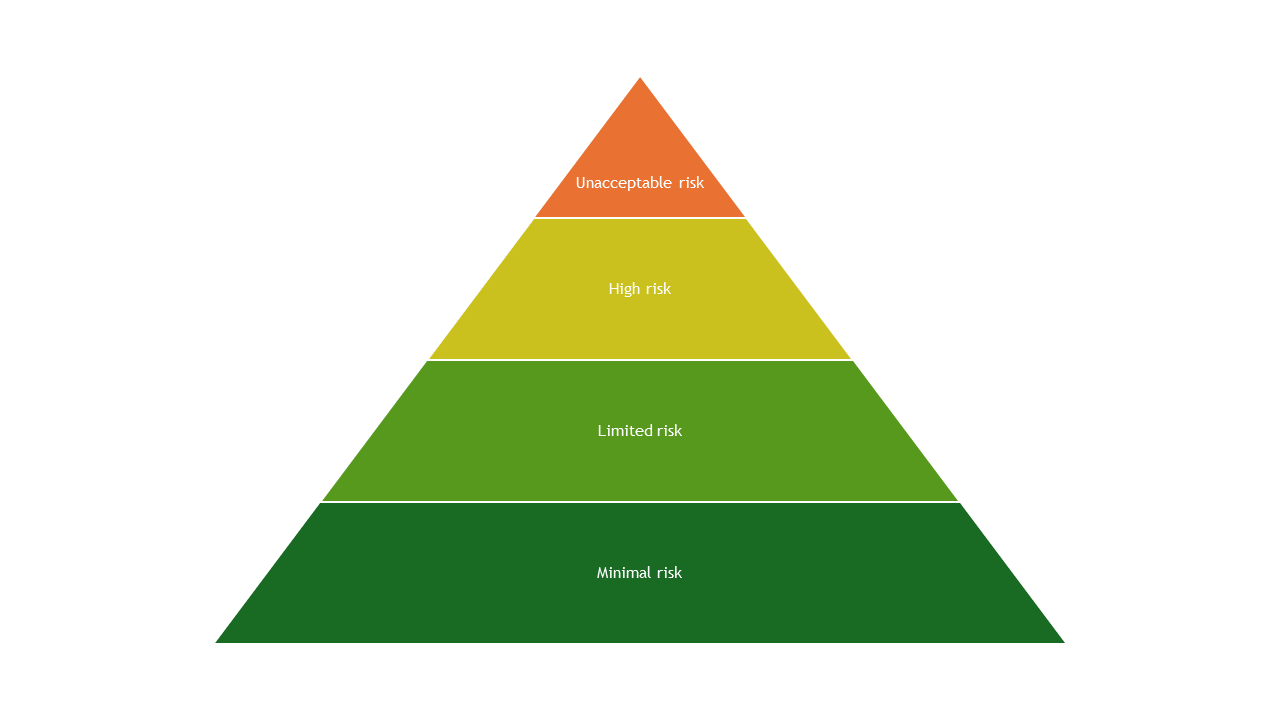

De wetgeving heeft een risico-gebonden aanpak gebaseerd op 4 risiconiveaus (figuur 1). Afhankelijk van het risico van de AI-toepassing moet er aan andere criteria voldaan worden.

Figuur 1: 4 risico niveaus binnen de AI act (bron: AI-wet | Shaping Europe’s digital future (europa.eu))

Er zijn maar een beperkt aantal toepassingen die onder onaanvaardbaar risico vallen. Dit zijn toepassingen die als bedreiging voor mensen worden beschouwd en dus verboden worden. Een voorbeeld is een AI-systeem dat een ‘sociale score’ geeft aan mensen, deze score wordt dan gebruikt om toegang te geven tot bepaalde maatschappelijke diensten.

Hoogrisicosystemen zijn toepassingen die worden ingezet in infrastructuren waarbij het leven en de gezondheid van burgers in gevaar kunnen komen. Alle producten die onder de EU-wetgeving inzake productveiligheid vallen, worden tot deze categorie gerekend wanneer ze een AI-toepassing bevatten. Dit zijn bijvoorbeeld AI-toepassingen voor transport of wervingsprocedures. Deze systemen worden aan strenge eisen onderworpen waaronder risicobeperking en traceerbaarheid. Om een hoog risico AI-systeem op de markt te brengen, moet er eerst een procedure doorlopen worden. Er zal een evaluatie van het AI-systeem gebeuren en het moet geregistreerd worden in een EU-database. Als het systeem aan alle voorwaarden voldoet, zal het een CE-keurmerk krijgen en kan het op de markt gebracht worden. AI-aanbieders blijven verantwoordelijk voor de monitoring van het systeem eens het op de markt is gebracht.

Een beperkt risico betekent een systeem dat een gebrek heeft aan transparantie. Mensen moeten geïnformeerd worden als er AI aan te pas komt; er is een transparantieverplichting. Zo kan de gebruiker een weloverwogen beslissing maken. AI-gegenereerde inhoud moet ook identificeerbaar zijn. Mensen moeten bijvoorbeeld weten als ze met een chatbot communiceren.

Veel toepassingen die nu al in de EU gebruikt worden, vallen onder minimaal of geen risico. Een toepassing is bijvoorbeeld een spamfilter. AI-systemen voor kwaliteitscontrole in fabrieken vallen ook onder deze categorie.

Voor bedrijven is het belangrijk dat de AI-systemen die ze gebruiken, voldoen aan de EU-regelgeving en indien van toepassing een CE-markering hebben. Dit geldt vooral voor systemen die als hoog risico zijn geclassificeerd.

De AI-wet is in werking getreden in augustus 2024 en is twee jaar later volledig van toepassing, hierop zijn enkele uitzonderingen. De wet heeft een graduele aanpak: systemen met een onaanvaardbaar risico moeten bijvoorbeeld al na 6 maanden afgebouwd worden.

De wetgeving is toekomstbestendig wat betekent dat de regels kunnen aangepast worden als er technologische veranderingen zijn. Aanbieders moeten dus ook nadat het product op de markt is gebracht kwaliteit en risicobeheer uitvoeren.

Wat met innovatie?

Er is bezorgdheid dat de AI Act en de vele aspecten waarmee rekening gehouden moet worden bij ontwikkeling van AI een drempel kan vormen voor innovatie. Op Vlaams niveau is er al een beleidsplan voor AI om deze drempel te verkleinen. In de AI Act is er een nieuw concept om deze drempel te vermijden/verlagen: de AI regulatory sandsbox.

Een sandbox is een gecontroleerde omgeving die het ontwikkelen, testen en valideren van innovatieve AI-systemen voor een beperkte tijd mogelijk maakt. Bedrijven kunnen toezicht en feedback ontvangen over onder andere de regelgeving. De sandboxes zouden marktintroductie moeten verkorten. De regulatory sandboxes worden ook gebruikt om te bepalen of een AI-systeem binnen het hoge risico niveau valt.

Daarbovenop heeft de regelgeving als doel het vertrouwen te vergroten waardoor er misschien meer vraag komt naar AI-systemen en innovatie. Door meer rechtszekerheid en geharmoniseerde regels streeft de AI Act naar een toegang tot een grotere markt voor AI-aanbieders. De regels zullen ook enkel van toepassing zijn waar het noodzakelijk is om zo de last te beperken.

Bronnen

AI-wet | Shaping Europe’s digital future (europa.eu)

Artificial Intelligence – Q&As (europa.eu)

Groen licht voor Europese AI Act, wat betekent dat nu juist? | Agoria

EU AI Act: first regulation on artificial intelligence | Topics | European Parliament (europa.eu)

Ook interessant!

Ben je benieuwd naar de rol van AI in de voedingsindustrie? Wil je weten welke subsidies beschikbaar zijn, wat er al gebeurt in de sector en welke innovaties eraan komen?

Kom dan naar het evenement: AI in de Voedingsindustrie: What's Up and What's Coming?!

De inzet van AI speelt een belangrijke rol in de transformaties van Industrie 4.0. Benieuwd hoe jouw bedrijf scoort op het gebied van Industrie 4.0 en hoe die prestaties zich verhouden tot het gemiddelde in de voedingssector?

Ontdek concrete verbeterpunten en groeikansen met de FOF-scan, dé benchmarkingtool voor jouw bedrijf.